-

ตรวจสอบการจัดหาข้อมูลเข้าสำหรับระบบปัญญาประดิษฐ์

ก่อนหน้านี้มันเป็น คอมเล่มเกมกับคอมกันเอง เพื่อฝึกฝน ต่อไปมันจะเป็น คอมสร้างเกมขึ้นมาให้คนเล่นตามเกมนั้น เพื่อฝึกฝน

-

ตัวชี้วัดเป็นคนละอย่างกับสิ่งที่มันวัด

พยายามมองหาตัวชี้วัดมากเสียจนมองไม่เห็นสิ่งที่เป็นสาระรึเปล่า

-

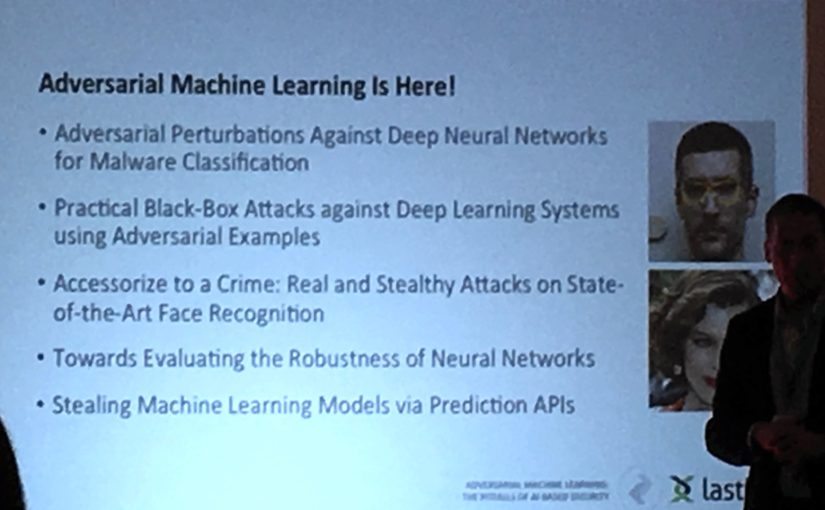

จุดอ่อนของ AI ในงานความมั่นคงปลอดภัยทางสารสนเทศ #infosec17

ปัญญาประดิษฐ์กับความมั่นคงไซเบอร์ AI ฉลาด แต่ก็ถูกหลอกได้ ถ้าจะเอามาช่วยงานความมั่นคงปลอดภัยทางสารสนเทศต้องระวังอะไรบ้าง สรุปจากงาน Infosecurity Europe 2017

-

mloss – free as in speech, not in will (yet)

mloss – Machine Learning Open Source Software Community ชุมชนซอฟต์แวร์โอเพนซอร์สด้านการเรียนรู้ด้วยเครื่อง วารสารวิชาการ Journal of Machine Learning Research – Open Source Software Track [ ผ่าน kindml ] technorati tags: machine learning, open source, free software

-

YALE – Yet Another Learning Environment?

YALE – Yet Another Learning Environment? ถ้าใครรู้จัก Weka .. นั่นแหละ มันคือประมาณ Weka แหละ (ซอฟต์แวร์สำหรับเอาไว้ทดลอง การเรียนรู้ของเครื่อง / การทำเหมืองข้อมูล) แต่ดูสดกว่า คงเพราะมาทีหลัง มีเครื่องมืออำนวยความสะดวกเพิ่มเติมจากที่ Weka มี อย่างตัวเลือก feature หรือเรื่อง XML อ้อ ใช้ตัว classifier/clusterer ของ Weka ใน YALE ได้ด้วยนะ อ่านฟอร์แมต ARFF ของ Weka ก็ได้ ดูจากภาพหน้าจอ YALE ทำ visualization ได้สวยกว่าด้วย YALE is an environment for machine learning experiments and data mining.…